В 2021 году ионных квантовых компьютеров в России фактически не было. Физики уже умели составлять необходимые для компьютера цепочки из ионов, но в них даже не было полноценных кубитов. Сегодня ученые из ФИАН проводят операции уже на 20-кубитном вычислителе из ионов иттербия и продолжают повышать точность операций. Один из руководителей проекта и лауреат премии «ВЫЗОВ» 2023 года Илья Семериков рассказал N + 1, как устроены эти квантовые компьютеры и есть ли у них какое-то будущее.

Этот материал появился на N + 1 в рамках спецпроекта «Это на будущее», который реализуется при поддержке Национальной премии в области будущих технологий «ВЫЗОВ». В 2023 году премию «ВЫЗОВ» присудили в четырех номинациях: «Перспектива» — за создание ионного квантового процессора, «Инженерное решение» — за технологию создания магнитов из высокотемпературного сверхпроводника, «Прорыв» — за исследования в области создания вычислительных устройств на основе поляритонов и разработку оптического транзистора и «Ученый года» — за открытия, позволившие создать новые подходы для лечения заболеваний мозга. В этом году у премии появилась международная номинация Discovery («Открытие»), которая будет присуждена за важное открытие, повлиявшее на развитие в области науки и технологий. Подача заявок на соискание премии «ВЫЗОВ» 2024 года открыта до 20 мая.

N + 1: Как вам удалось так быстро добиться прогресса?

Илья Семериков: По квантовым вычислениям мы начали работать в конце 2019 года, и ионы в первой версии ловушки у нас были в начале 2020 года.

До квантовых вычислений мы строили прецизионные атомные часы на оптическом переходе в ионе иттербия-171 — на том же переходе, который сейчас используем в качестве кубитного. Это позволило нам очень быстро влиться в тему квантовых вычислений, потому что основные строительные блоки квантовых компьютеров и часов очень похожи. Там используется и доплеровское охлаждение, и спектроскопия узких переходов, и ионные ловушки, и глубокий вакуум — все как в квантовых компьютерах.

И на самом деле мы не единственная такая группа, которая шла по этому пути. Большая часть ионных групп, которые сейчас делают квантовые компьютеры, начинали со стандартов частоты.

С 2020 года мы много чего научились делать. Прежде всего, мы сделали два поколения ионных ловушек. На ловушке первого поколения мы отработали базовые вещи — однокубитные и двухкубитные операции. В конце 2021 года у нас в лаборатории были первые кубиты. А почти сразу после этого — и кудиты

Уже тогда мы приняли решение двигаться именно в этом направлении.

В 2022 году мы изготовили новую ловушку, где ионы греются гораздо меньше, а живут дольше. Также мы научились лучше управлять самими двухкубитными операциями. Если раньше для этого мы просто прикладывали к перепутываемым ионам лазерный импульс постоянной амплитуды, то теперь мы стали использовать импульсы с более сложной зависимостью амплитуды от времени. Это дало возможность сделать гейты более быстрыми и устойчивыми к шумам.

Все это позволило нам получить уже восемь ионов в цепочке (то есть 16 кубит) и к концу 2022 года начать проводить первые квантовые алгоритмы. К концу 2023 года мы фундаментально переработали лазер, который используется для манипуляций с кубитами, и смогли существенно увеличить достоверность

как однокубитных, так и двухкубитных операций. Еще мы переработали системы адресации и считывания и перешли к работе с 10 ионами и, соответственно, 20 кубитами.

А с какого момента вы начали считать, что имеете уже не просто ионы в ловушке, а квантовый компьютер?

Ну, это вопрос определения, но мы стали называть это компьютером после того, как провели перепутывающую операцию между двумя ионами, то есть когда в нем было два иона и четыре кубита.

А какие еще были причины для использования кудитов, кроме той, что у вас под рукой уже был иттербий, у которого было четыре уровня?

Вообще говоря, кудиты можно реализовывать на очень разных ионах, необязательно на иттербии: и на бериллии, и на магнии, и на кальции, и на стронции, и на барии, — так что дело было не в том ионе, который оказался под рукой.

Почему мы сразу пошли именно в сторону кудитных вычислений? У этого есть несколько причин. Первая причина — чисто научная. Тема ионных квантовых вычислений уже даже не первый десяток лет существует и многое сделано, причем на очень высоком уровне. И только на то, чтобы реализовать у себя те технологии, которые уже были придуманы до нас, у нас ушло почти четыре года. А хочется же при этом еще и какие-то оригинальные результаты получать. Кудитная ниша, с одной стороны, интересная, то есть там понятно, за что бороться. Но с другой стороны, она была существенно недоисследована.

К тому же у нас есть коллеги из группы Алексея Федорова, которые предложили нам интересный набор алгоритмов, эффективно раскрывающих потенциал кудитов. В результате у нас были теоретические идеи, техническая возможность их реализовать плюс интересная научная ниша, которая на тот момент еще не была достаточно глубоко исследована.

Прежде чем углубляться в технические подробности, можете рассказать, что собой вообще представляет ваш компьютер?

Наша установка устроена довольно традиционно для ионных квантовых компьютеров. Она состоит из нескольких основных блоков.

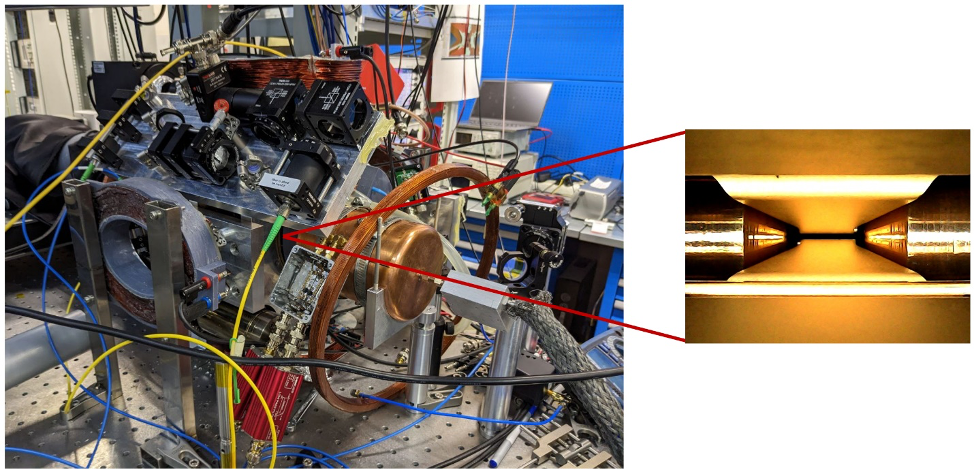

Квантовый компьютер и ионная ловушка в нем

Илья Семериков

Все начинается с того, что ионы какого-то металла (в нашем случае это иттербий) захватываются в электромагнитную ловушку, которая называется ловушкой Пауля. Мы берем трубочку с металлическим иттербием в глубоком вакууме уровня 10‑11 миллибар, нагреваем ее — и возникает поток атомов иттербия

Ионная ловушка

Илья Семериков

После этого мы проводим их изотопно-селективную фотоионизацию. Таким образом мы можем использовать естественную изотопную смесь, но выделять из нее и захватывать в ионную ловушку только нужный нам изотоп. Дальше происходит доплеровское охлаждение ионов при помощи довольно большой лазерной системы — трех лазеров и четырех электрооптических модуляторов.

Как работает доплеровское охлаждение?

Если я правильно помню, то смысл доплеровского охлаждения в том, что мы светим на атом лазером с частотой чуть меньше, чем та, на которой он поглощает. Он не может поглотить это излучение просто так, но при движении в сторону лазера из-за эффекта Доплера частота света для атома немного повышается, он поглощает фотон и теряет импульс в этом направлении. И поскольку фотоны переизлучаются одинаково во все стороны, то, если поставим лазеры по всем осям координат, мы сможем полностью затормозить атомы, правильно?

В целом правильно, но с ионами здесь есть заметное отличие от нейтральных атомов: одного лазерного пучка достаточно, и светить им можно почти откуда угодно, и ион через некоторое время все равно охладится. Дело в том, что все его траектории замкнуты и он рано или поздно полетит навстречу пучку.

Это он под действием ловушки так движется?

Да, и за счет этого для охлаждения достаточно одного лазера.

Но вы же говорите, что у вас используются три лазера и еще модуляторы?

Если бы у нас была двухуровневая система, там действительно хватило бы одного лазера, можно было бы просто посветить, и все было бы хорошо. Но у нас система многоуровневая, и проблема заключается в том, что с верхнего уровня, использующегося для охлаждения, распад может произойти не только в основное состояние, но и в другое, долгоживущее, состояние. Для охлаждения ион должен постоянно поглощать и излучать фотоны, и, застревая в этом метастабильном состоянии, он перестает охлаждаться.

Для решения этой проблемы используются лазеры-репамперы, которые из этого метастабильного состояния возвращают его в основное. У нас два таких репампера стоят для возврата ионов с двух разных метастабильных уровней.

Если бы мы работали с четными изотопами иттербия, например 174 или 172, то этого было бы достаточно. Но так как у нашего иттербия-171 спин ядра равен 1/2, у него еще больше таких состояний-ловушек. Чтобы доставать ионы оттуда, приходится еще и модулировать излучение охлаждающего лазера и лазеров-репамперов по фазе при помощи электрооптических модуляторов.

Хорошо. Вот мы поймали ионы, охладили их — что дальше?

Дальше нам нужно охладить их еще сильнее. Ведь в реальности после доплеровского охлаждения ион имеет в среднем около 30 колебательных квантов энергии, или, другими словами, находится примерно на 30-й, а иногда, бывает, и на 100-й ступеньке лестницы колебательных подуровней, возникающей во внешнем потенциале ловушки.

И если мы хотим, чтобы все ионы оказались в основном колебательном состоянии, то есть внизу этой лестницы, нам надо все эти 30 лишних колебательных квантов забрать у иона. Мы их отнимаем по одному или по два. И делаем это при помощи проведения на этих ионах однокубитных операций. Мы берем наш кубитный лазер — это уже пятый, после трех охлаждающих и одного для фотоионизации, — и делаем такой лазерный импульс, частота которого меньше частоты нашего перехода ровно на величину частоты колебаний иона в ловушке...

Но интуитивно кажется, что когда стреляешь лазером по иону и он настроен на частоту разницы между двумя уровнями, то можно поднять электрон на уровень вверх. А как его опустить вниз?

Да, это отдельная история. На самом деле его можно и вниз опустить. Если мы возьмем долгоживущую двухуровневую систему и начнем светить лазером, настроенным в резонанс, то увидим осцилляцию заселенности, так называемую осцилляцию Раби. То есть сначала будет увеличиваться заселенность верхнего состояния, дойдет до единицы, а потом станет падать, дойдет до нуля и так далее. И мы просто светим столько времени, чтобы оно повернулось до нужного нам состояния, что эквивалентно проведению однокубитной операции.

В целом процедура охлаждения до основного колебательного состояния очень важна, потому что она одна из самых длинных. В алгоритме она может занимать 5–7 миллисекунд, притом что одна однокубитная операция занимает около 5 микросекунд. То есть за время такого глубокого охлаждения мы успели бы сделать несколько тысяч операций.

Мы их охладили до основного колебательного состояния. Что после этого?

А дальше мы уже начинаем проводить операции. И тут нужно выбрать, что у нас будет кудитом. При этом здесь важно, чтобы верхнее состояние было долгоживущим, так как главное требование к кубитным состояниям — чтобы они жили долго.

Насколько долго?

Много дольше, чем время проведения алгоритма.

В иттербии мы можем записать кудит либо в квадрупольном оптическом переходе

2S1/2 F=0 → 2D3/2 F=2, либо использовать сверхтонкое расщепление 2S1/2 F=0 → 2S1/2 F=1 в микроволновом диапазоне. Сейчас мы работаем с оптическим кудитом и используем состояние 2D3/2, так как у него время жизни в верхнем уровне составляет 53 миллисекунды. У 2D5/2, например, 11 миллисекунд, и этого уже точно недостаточно.

Энергетические уровни иона иттербия

Илья Семериков

Подождите, а какие четыре уровня здесь для кукварта используются?

При приложении магнитного поля состояние 2D3/2 F=2 за счет эффекта Зеемана распадается на пять подуровней. Кукварт включает три из этих подуровней и основное состояние 2S1/2 F=0.

Куквартные подуровни иона иттербия

Илья Семериков

У вас есть шесть уровней, которые вы можете использовать: основной (2S1/2 F=0) и пять возбужденных (2D3/2 F=2). Почему бы тогда не сделать на них три кубита, а не два?

Для того чтобы сделать три кубита, нужно восемь уровней. Размерность пространства состояний для n кубит — 2n. Поэтому нам нужно 2n уровней для описания этого пространства.

Наивное представление состоит в том, что для создания одного кубита нужно два энергетических уровня, и неважно, брать эти уровни из разных атомов или из одного и того же. Почему мы не можем из шести уровней одного атома сделать три независимых кубита по два уровня каждый, которые мы могли бы потом запутать и получить сразу восемь измерений пространства состояний?

Проблема в слове «независимых». Внутри атома разные состояния не являются независимыми, поэтому просто сравнивать общее количество уровней внутри одного атома и в нескольких нельзя. Более того, как мы уже обсуждали, с ростом количества кубитов, которые мы хотим закодировать в один ион, требуемое количество уровней растет экспоненциально.

Поэтому построить большой квантовый компьютер всего на одном атоме вряд ли получится (хотя высказывались предложения делать огромные кудиты, например, на основе молекул, в которых очень много колебательно-вращательных подуровней). А вот увеличить эффективное количество кубитов в имеющихся сегодня мультиионных системах в два-три раза вполне можно, причем без особенного усложнения установок.

Встает вопрос: как кудитами пользоваться при выполнении квантовых алгоритмов, которые почти все написаны для обычной кубитной архитектуры? Тут есть три возможных подхода. Первый — полностью переделать алгоритм, исходя из поддерживаемых данным компьютером типов кудитов и операций с ними. Такие алгоритмы будут наиболее эффективными с точки зрения точности и требуемых ресурсов, однако их еще очень мало, и придется придумывать с нуля.

Второй подход — портировать известные кубитные алгоритмы на кудиты. Мы просто ставим в соответствие каждому из четырех уровней кудита некоторое состояние эквивалентной двухкубитной системы. Дальше можно работать с кудитом как с двухкубитной системой внутри одного иона. Так как в этом случае при создании исходного алгоритма не учитываются особенности кудитов, они будут не такими оптимальными. Но даже такой прямолинейный подход дает свои бонусы.

Двухкубитные операции между несколькими ионами сильно дороже, чем однокубитные. Однокубитная операция у нас сейчас имеет достоверность 99,95 процента, а двухкубитная — от 95 до 97 процентов, то есть ошибка на два порядка выше. Другими словами, это значит, что каждая двухкубитная операция стоит как 100 однокубитных. Поэтому, когда нам присылают алгоритм, мы даже не смотрим, сколько там однокубитных, мы спрашиваем только, сколько в нем двухкубитных операций.

И вот здесь, даже при прямой трансляции кубитных алгоритмов на кудиты, они уже дают выигрыш, потому что в них некоторые двухкубитные операции начинают стоить как однокубитные, поскольку они происходят внутри одного иона. Но некоторые все равно продолжают стоить как честная двухкубитная операция.

Это уже неплохо. Но есть и третий, промежуточный путь: мы можем по-прежнему использовать для основного хранения информации в ионах лишь два уровня, а дополнительные состояния использовать временно, как анциллу. То есть при необходимости «положить» туда состояние, чтобы оно там лежало как в буфере памяти, пока мы выполняем другие операции, а потом мы оттуда его забираем. Получается, что мы продолжаем работать в хорошо изученной кубитной парадигме, но получаем доступ к некоторым дополнительным ресурсам. Иногда это дает существенный выигрыш.

Если оценивать квантовый компьютер по количеству кубитов в нем, то в квантовой гонке однозначно лидируют Google и IBM со своими сотнями, а то и тысячами сверхпроводящих кубитов. Но вы говорите, что ионные компьютеры с ними находятся наравне или, может быть, даже превосходят их. А число кубитов в них исчисляется только десятками. Так как лучше измерять производительность и сравнивать друг с другом разные квантовые компьютеры?

Вообще, основная предпосылка квантовых вычислений заключается в том, что размерность пространства состояний, в котором мы работаем, растет с числом кубитов как 2n, где n — это число кубитов. И если бы размерность пространства, в котором работает, например, компьютер от IBM, была 21121, по числу кубитов в самой большой системе, которая у них сейчас есть, то, скорее всего, было бы уже продемонстрировано какое-то полезное квантовое превосходство. То есть была бы решена какая-то полезная задача принципиально быстрее, чем на классическом компьютере.

Но пока ничего и близко к этому нет. Потому что, чтобы действительно использовать преимущества пространства такой размерности, нужно иметь почти 100-процентную достоверность запутывающих операций и с абсолютной точностью управлять кубитами. Иначе реально большинство состояний из этого пространства вам просто недоступно — номинально есть, а сколь-нибудь детерминистически их создать вы не можете.

При этом компания IBM, как ни странно, сама же и ввела метрику, называемую квантовым объемом, которая более объективно отражает вычислительную мощь компьютера. Про нее можно очень упрощенно сказать, что это размерность пространства, в котором мы реально можем работать. На самом деле там есть конкретный алгоритм, который нужно провести, и объем определяется по результату этого алгоритма. Условно, если вы на n кубитах смогли провести подряд n слоев произвольных двухкубитных операций, где в слое все кубиты делятся на произвольные пары и перепутываются, то вы имеете квантовый объем 2n. Немного похоже на индекс Хирша. В целом неплохая метрика , хотя и не всеобъемлющая.

Есть и другие метрики. Компания IonQ, например, ввела метрику «алгоритмических кубитов», когда поняла, что они не могут бороться в терминах квантового объема с ионным компьютером компании Honeywell

В конечном счете все эти метрики сводятся к достоверности двухкубитной операции и связности, то есть к тому, между какими парами кубитов можно провести эту двухкубитную операцию. В ионном компьютере ее можно проводить между любыми двумя кубитами, а в сверхпроводящем — только между соседями. Поэтому, если вы хотите перепутать два удаленных сверхпроводящих кубита, вам придется провести запутывающую операцию по цепочке между всеми промежуточными. Пока вы доберетесь до последнего, запутанность частично рассеется, и вы получите ошибку во столько раз больше, сколько дополнительных операций запутывания вам пришлось сделать.

И какой квантовый объем в результате получается у компьютера IBM на тысячу кубитов?

О тысячекубитной системе пока почти ничего не известно, они ее никак не характеризуют. А самое большое число, которое они когда-либо демонстрировали, было получено на системе гораздо меньшей размерности, и оно составляет 29.

А на скольких кубитах было получено это число?

В этом процессоре было всего 27 кубитов, потому что чем меньше ваша система, в том числе и сверхпроводящая, тем проще ее воспроизвести. И люди всегда стараются сделать систему как можно меньше, чтобы на ней получались лучше результаты. Например, Google показывал свое квантовое превосходство на 53-кубитной системе, притом что у них была уже к тому моменту 72-кубитная.

Но если вернуться к сравнению с IBM, то у компании Honeywell квантовый объем составляет 219, хотя ионов всего в этой системе 32. То есть и они тоже ограничены достоверностью двухкубитных операций, притом что достоверность этих операций у Honeywell 99,8 процента, у IonQ — в среднем 99,6 процента.

А какая достоверность у вас?

У нас сейчас достоверность двухкубитных операций на разных парах ионов разная: на худшей паре она порядка 90 процентов, на лучшей — порядка 97 процентов. Впрочем, всегда есть некоторый разброс по достоверностям, и еще большой вопрос в том, как это аккуратно мерить, поэтому я бы пока эти результаты назвал скорее заниженными. В среднем у нас сейчас достоверность порядка 95 процентов.

И именно она ограничивает то, какие алгоритмы мы можем проводить. То есть мы, в отличие от IBM, можем прилично сделать порядка десяти двухкубитных операций. Хотя на некоторых алгоритмах, которые не требуют полной запутанности, мы делали и больше — 14 или даже 20 операций.

То есть, если мы ориентируемся на ваши 20 кубит на куквартах, вам сейчас нет смысла наращивать число ионов в ловушке, а нужно повышать качество двухкубитных операций? Как вы это делаете?

Как ни странно, сейчас достоверность наших двухкубитных операций во многом ограничена просто временем когерентности, то есть временем жизни верхнего состояния. Сейчас двухкубитную операцию мы проводим за 500–800 микросекунд, и, если посчитать экспоненту распада, мы получим достоверность проведения 10 двухкубитных операций подряд на уровне от 95 до 98 процентов.

Перед этим мы решили целый набор других проблем, в частности с фазовой чистотой лазера и темпами нагрева. Сейчас мы, похоже, уже добрались просто до времени когерентности.

Что с этим можно делать? Две вещи: первое — уменьшать время двухкубитной операции, второе — использовать для кубитов состояния с бо́льшим временем жизни.

Что значит «уменьшить время операции»? На самом деле это значит более эффективно использовать мощность лазера. Понятно, что если увеличить мощность лазера, то время операции уменьшится, но сильно увеличить ее нельзя по чисто техническим причинам, связанным с деградацией кристаллов акустооптических модуляторов. Но можно делать более эффективные шейпы импульсов, чтобы более эффективно возбуждать и девозбуждать колебания.

Подождите, а какие четыре уровня здесь для кукварта используются?

При приложении магнитного поля состояние 2D3/2 F=2 за счет эффекта Зеемана распадается на пять подуровней. Кукварт включает три из этих подуровней и основное состояние 2S1/2 F=0.

Что такое эффективные шейпы?

А как сделать шейпированные импульсы более эффективными?

Тут придется немножко углубиться в детали. Откуда вообще берутся шейпы? Почему мы светим не квадратным импульсом, а каким-то сложным по времени? Почему у нас временная зависимость для импульса двухкубитной операции такая сложная?

Это связано с тем, что на самом деле у нас не одна колебательная степень свободы, а 20: 10 ионов и две оси в радиальной плоскости ловушки — вот и получается 20. Все эти степени свободы довольно близко расположены по частотам, и если мы пытаемся возбудить одну из этих колебательных мод, то возбуждаем сразу и все остальные, а потом нужно их же все девозбудить обратно в конце операции. Для этого мы делаем импульс не квадратным, а некоторой сложной формы, потому что манипулируем не простым колебанием одного атома, а сложным колебанием всех атомов одновременно.

То есть можно сказать, что повышение эффективности шейпа — это по сути более умелое обращение с этим колебанием всех атомов одновременно?

Ну да. Это требует непростых квантово-механических расчетов, но мы сейчас некоторых успехов в этом добились и чуть сократили время операции.

Вторая история — это перейти от оптического кубита, на котором мы сейчас работаем, к микроволновому, сделанному на переходе 2S1/2 F=0 → 2S1/2 F=1. Состояние 2S1/2 F=1 при приложении магнитного поля расщепляется на три, и в сумме мы получаем четыре уровня, на которых тоже сможем работать с куквартами. Там, правда, не получится сделать еще

или алгоритм защиты от магнитного поля, потому что нет дополнительных уровней. Но на самом деле нам это не очень-то и нужно. Чувствительность к магнитному полю для этого перехода меньше, плюс мы можем лучше его заэкранировать, так что проблема защиты решается.

Электронные переходы для микроволнового кубита

Илья Семериков

Для анцилл мы собираемся в будущем использовать 5 верхних уровней, на которых у нас сейчас работает оптический кубит. Для этого потребуется замодулировать излучение кубитного лазера на частоте 12,6 гигагерца, и тогда мы сможем его использовать для управления обеими группами уровней одновременно. Это наше ноу-хау, в мире на универсальных компьютерах никто до сих пор еще не научился так делать.

То есть вы, по сути, хотите, чтобы в одном ионе был и куквартный процессор на четырех нижних уровнях (2S1/2 F=0 → 2S1/2 F=1), и кэш для него на оставшихся пяти верхних (2D3/2 F=2). А какое время жизни у микроволновых уровней 2S1/2 F=1, на которые вы собираетесь переходить?

Фактически бесконечное. На них экспериментально продемонстрировали время когерентности час. Это вообще самое большое время когерентности, которое когда-либо на чем-либо было продемонстрировано.

Это китайская группа сделала, но у них был несколько синтетический эксперимент, в котором ион специально стабилизировали за счет проведения над ним разных однокубитных операций. Если не стабилизировать его, а просто использовать для вычислений, немного заэкранировав магнитное поле, то вполне можно достигнуть времени в десятки секунд.

Это сильно лучше, чем миллисекунды.

Да, это в тысячу раз больше, чем десятки миллисекунд, и в результате время когерентности нас, скорее всего, перестанет ограничивать.

Кудиты для разложения

Какие алгоритмы вы можете выполнять на таких системах?

Прежде всего, надо понимать, мы сами не алгоритмисты. То есть алгоритмы до какой-то степени, конечно, понимаем, но мы в них не профессионалы. Поэтому честный ответ на вопрос «Какие мы делаем алгоритмы?» — «Те, что дают».

Например, из того, что нам давали в последнее время и над чем мы довольно долго провозились, это алгоритмы разложения числа на простые множители.

А, старый-добрый Шор...

Только не Шор, а Шнорр. Несколько лет назад был предложен алгоритм Шнорра, который изначально вообще был чисто классическим. И якобы благодаря ему шифрование RSA становилось неактуальным, потому что можно было большие числа легко раскладывать на простые множители. Но оказалось, что нет, в этом алгоритме есть узкие места, которые изначально были неочевидны. Сейчас разные группы пытаются его улучшать, предлагая к нему, скажем так, квантовые заплатки.

Одну из таких заплаток мы тестировали — получилось, что алгоритм работает (мы показываем разложение), но для квантового превосходства этой системе не хватает размерности. Если увеличить размерность системы, оно появится, но пока такого компьютера, чтобы настолько увеличить размерность, у нас нет. Тем не менее остается фактом, что мы с помощью этого алгоритма разложили на простые множители число 1591.

Другие классы алгоритмов, которые мы довольно активно запускали, — это алгоритмы машинного обучения, где несколько классических слоев были заменены на квантовые и проводились на квантовом компьютере. Вообще, пока почти все наши алгоритмы, которые имеют какое-то практическое приложение, комбинированные. То есть состоят из большого классического куска и какой-то квантовой части, которая там что-то улучшает.

А какие еще перспективные алгоритмы вам хотелось бы запускать в будущем?

Есть работа, которую мы уже сделали и будем публиковать, — это проведение гейтов Тоффоли

именно в кудитной парадигме с использованием анцилл. И здесь мы видим существенное улучшение достоверности. То есть мы сначала проводим кубитный гейт Тоффоли, а потом делаем кудитный — и на той же самой системе видим очень существенное увеличение достоверности.

А почему такая большая разница между кубитами и кудитами?

Потому что в случае с кудитами мы делаем гораздо меньше двухкубитных операций за счет использования анцилл.

Я думал, что выигрыш идет за счет того, что двухкубитная операция внутри одного иона проходит легче...

Да, внутренние двухкубитные операции стоят как однокубитные, но здесь мы в обоих случаях четыре иона запускали как четыре кубита, но во втором случае один из дополнительных кудитных переходов использовали как анциллу, то есть вспомогательный уровень, куда мы состояние складывали, а потом забирали, и благодаря этому мы уменьшили число двухкубитных операций.

Компьютер из тысячи ионов

IonQ планирует к 2028 году иметь 32 логических, защищенных от ошибок ионных кубита на основе 1024 алгоритмических. Это правда возможно?

Было время, когда мне эти планы казались безумными. Но по мере того, как мы работаем над этой задачей, они мне кажутся все менее безумными.

Мне кажется, что, с одной стороны, в алгоритмах коррекции ошибок будут прорывы. Например, совсем недавно вышла совместная статья Honeywell и Microsoft об алгоритмах коррекции ошибок. Там совсем немного ионов использовали для кодирования кубита, и авторы говорят, что у них одна ошибка на четырнадцать тысяч двухкубитных операций.

Одна ошибка на четырнадцать тысяч... Это, кажется, даже слишком хорошо.

Тем не менее это статья, и статья экспериментальная.

А сколько у них кубитов?

По-моему, у них используются четыре логических кубита. Физических — точно не больше тридцати двух, может быть, даже меньше. Это очень хороший результат.

Даже более чем...

У ребят просто двухкубитная операция очень хорошая. Даже обычные двухкубитные операции у них с достоверностью 99,8 процента. Может, они уже подняли ее до 99,9 процента. Тем не менее мне кажется, что такие уровни — 99,8, 99,9 процента — в целом достижимы, осязаемы. Они не являются чем-то безумным.

С другой стороны, масштабирование самого процессора Honeywell может оказаться сложнее, потому что у него запутывание работает только с парами ионов. Благодаря этому у них получается достигать такой высокой точности. Но за это приходится платить очень сложными ловушками: на один ион там приходится примерно 20–25 контролируемых электродов.

Мне же ближе подход, когда мы работаем с цепочками где-то из 10 ионов. У нас сейчас такая есть, и на самом деле нам больше ионов внутри одной цепочки не надо. Дальше нужно делать несколько цепочек в разных местах. И потом делить эти цепочки пополам, половинки из этих цепочек соединять в третьи ловушки, там их перепутывать, а затем задвигать обратно. Это позволит существенно снизить количество контролирующих электродов: мы ожидаем, что в нашей архитектуре это соотношение останется порядка одного электрода на ион. И при такой архитектуре задача контролировать 1000 ионов выглядит вполне реализуемо.

Докуда реально масштабировать ионные компьютеры в ближайшие лет пять — и по количеству ионов, и по квантовому объему?

Тут важно оговориться, что есть две разные цифры. Одна цифра, под которой я готов подписаться в рамках технического задания, — тут мы обещаем порядка 60 кубит с достоверностью 99 процентов к 2030 году. Это 30 ионов.

А есть видение — то, куда мы стремимся. И то, над чем мы сейчас только начинаем работать. Это так называемые 2,5-мерные ловушки.

2,5-мерная ионная ловушка. Сверху и снизу — два чипа с электродами, на каждом из которых планарная ионная ловушка Silke Auchter et al., Quantum Science and Technology, 2022

Изначально ловушки были трехмерными, у них четыре стержня располагались вокруг цепочки ионов. Можно эти же четыре электрода расположить на плоскости — это будет планарная ловушка. Honeywell и IonQ, например, используют планарные ловушки, и вообще масштабируемые ловушки почти всегда планарные.

Но с этими планарными ловушками связано много проблем: у них и глубина потенциала меньше, что приводит к потерям ионов, и темпы нагрева выше — за счет того, что ион приходится располагать ближе к поверхности. В связи с этим появилось предложение использовать несколько слоев печатных плат с электродами. Тогда есть электроды сверху, есть электроды снизу, а посередине между этими двумя слоями электродов летают ионы. Такая конструкция получается по архитектуре как планарная, но по свойствам она как бы эквивалентна обычной трехмерной ловушке. У них и с темпами нагрева все получше, и глубины большие.

В итоге у нас две большие ветки. Одна — на 10 ионах научиться делать операцию с достоверностью больше 99 процентов. И вторая ветка — это 2,5-мерные ловушки, которые позволят нам иметь один электрод на каждый из ионов, а там уже просматривается масштабирование на сотни ионов.

Мне кажется, это можно успеть сделать за ближайшие пять лет. Плюс у некоторых наших теоретиков также есть оригинальные идеи по тому, как реализовать коды коррекции ошибок, но это я спойлерить не буду.

Если нам удастся все это собрать, то, я думаю, мы сможем показать машины с квантовым объемом порядка 250 или даже выше — может быть, до 2100 — на горизонте где-то пять лет при общем числе кубитов порядка тысячи

Какими будут большие квантовые компьютеры?

Мое нынешнее представление о жизни заключается в том, что ионные квантовые компьютеры будут лидировать в эпоху мид-скейла, на масштабах тысяч, десятков тысяч, а может быть, до сотен тысяч кубитов. Мне кажется, что ионные кубиты быстрее всего доберутся до такого масштаба.

Не с точки зрения количества — сверхпроводниковый чип хоть завтра можно напечатать, в нем будет миллион кубит, никаких проблем. Но пока не будет решена проблема времени когерентности, ничего полезного с ним сделать не получится. В этом смысле и тысячу ионов поймать в ловушку — дело нехитрое. Требует некоторых навыков, но мы, например, в линию ловили 200 ионов без проблем. Две ловушки поставил — уже 400 ионов. Но история именно в том, чтобы работать.

Но вот как выглядел бы миллионоионный квантовый компьютер — я себе уже не представляю, поэтому мне кажется, что в лардж-скейле будет какая-то другая технология. То, что меня сейчас привлекает и интересует для лардж-скейла, — это, с одной стороны, спиновые кубиты, потому что они маленькие и у них большое время когерентности. Но пока с ними очень плохо с точки зрения управления, и кажется, что какое-то время пройдет, прежде чем они очухаются.

Есть еще фотонные компьютеры, но там тоже все не так безоблачно. Потому что длина волны света — это сотни нанометров, и я не верю, что кто-нибудь когда-нибудь уйдет в фотонных вычислениях под 100 нанометров. С такими длинами волн уже все оборудование деградирует так, что я бы и 300 нанометров использовать не стал. Но при этом у фотонного компьютера потенциально нет ограничений по размерам, его можно сделать и километр на километр.

Так что вот эти две технологии мне кажутся интересными на лардж-скейле.

А как, по-вашему, будет происходить внедрение квантовых технологий в жизнь?

Мне кажется, что мы немножко привыкли к быстрым результатам. Причем мы привыкли к ним ложно. Мы смотрим на классические компьютеры и видим, что 10 лет назад было сильно хуже, чем сейчас, возможности были сильно меньше. И думаем, что все должно развиваться по этой же кривой.

По экспоненте.

И не просто по экспоненте, а на последних годах этой экспоненты. А то, что классические вычисления развиваются с 1940-х годов, мы немного забываем. Мне кажется, что для квантового комьюнити сейчас правильно не сравнивать себя с нынешними компьютерами, а найти точку по времени, где квантовый компьютер сейчас пересекается с историей классических компьютеров по способности выполнять полезные задачи. Этот вопрос я сам себе задал пару дней назад и пока не знаю ответа, но он мне кажется важным.

Мой вопрос был скорее о том, какая практическая сфера первой почувствует на себе развитие квантовых компьютеров.

Какое-то время назад я на этот вопрос стабильно отвечал, что это химия — через то или иное квантовое моделирование. Но недавно мне пришла в голову такая мысль, что есть же AlphaFold и он тоже дает квазиэкспоненциальное превосходство над классическими вычислениями. Может быть, окажется, что в химии искусственный интеллект будет более продуктивным. Так что, может, химия, а может быть, и что-то другое.

Если первой будет химия, то что вторым?

Ну какие задачи хорошие для квантового компьютера? Когда мало информации на входе, мало информации на выходе и очень сложные вычисления посередине. Это могут быть какие-то логистические задачи, там не очень много точек на входе, простые относительно точки на выходе и экспоненциально сложные алгоритмы посередине.

А вот задачи взламывания RSA, вся эта криптография?

С одной стороны, мы пытаемся раскладывать числа на простые множители. Но с другой стороны, строить квантовый компьютер, чтобы взламывать шифры, — очень странная идея. Ведь квантовый компьютер — это же крайне сложная на уровне науки вещь, сложная с точки зрения фундаментальных основ вычислений.

Хотя это ведь так и работает. Nvidia свои чипы тоже делала для того, чтобы у ребят на компьютере черти быстрее грузились и были бы лучше прорисованы, а оказалось, что это путь к сильному искусственному интеллекту.

Пресс-служба Фонда «Вызов»

https://nplus1.ru/material/2024/05/17/trapped-ion-quantum-computer